Dans nos ordinateurs classiques, tout repose sur des systèmes binaires. Chaque opération, chaque image, chaque mot à l’écran est traduit en une série de 0 et de 1. C’est simple, rigide, et ça fonctionne comme un immense réseau d’interrupteurs. Les premiers ordinateurs, à lampes, utilisaient ce principe de façon très concrète. Une lampe allumée, c’était un 1. Éteinte, un 0. On empilait les circuits, on programmait les combinaisons, et l’information circulait.

Mais ce modèle binaire a ses limites. Un bit, c’est un interrupteur : allumé ou éteint, oui ou non, 1 ou 0. Les ordinateurs fonctionnent ainsi depuis plus de soixante-dix ans. Le qubit, lui, fonctionne autrement. Il ne choisit pas simplement entre 0 ou 1, il peut être dans une sorte de flou contrôlé entre les deux, un état qu’on appelle la superposition. Pour imager, c’est comme si un interrupteur n’était ni complètement allumé ni totalement fermé, mais dans une position intermédiaire qui dépend de l’observation. On peut aussi dire, comme le décrit IBM, que le qubit tourne dans une sphère complète, alors que le bit classique est coincé entre deux pôles fixes. Tant qu’on ne le mesure pas, il est un mélange de tous ses états possibles.

Et c’est là que tout déraille des cadres habituels. Dans un ordinateur classique, on avance un calcul à la fois, comme si on faisait la file. En informatique quantique, les qubits se déploient en parallèle, comme si chaque choix possible était exploré en même temps. Ce n’est pas qu’on ajoute des morceaux un à un, c’est qu’on bâtit un réseau entier d’options dès qu’on ajoute un seul qubit.

La machine ne suit plus une seule piste, elle s’éparpille volontairement, elle se permet des détours que les ordinateurs conventionnels ne savent même pas envisager. Et dans cette désorganisation apparente, il y a une puissance cachée. L’informatique quantique, ce n’est pas juste un nouveau moteur, c’est un changement de route. C’est ce qui la rend si prometteuse, surtout pour les problèmes qui demandent plus que de la force brute, pour ceux qui exigent une certaine finesse dans le chaos.

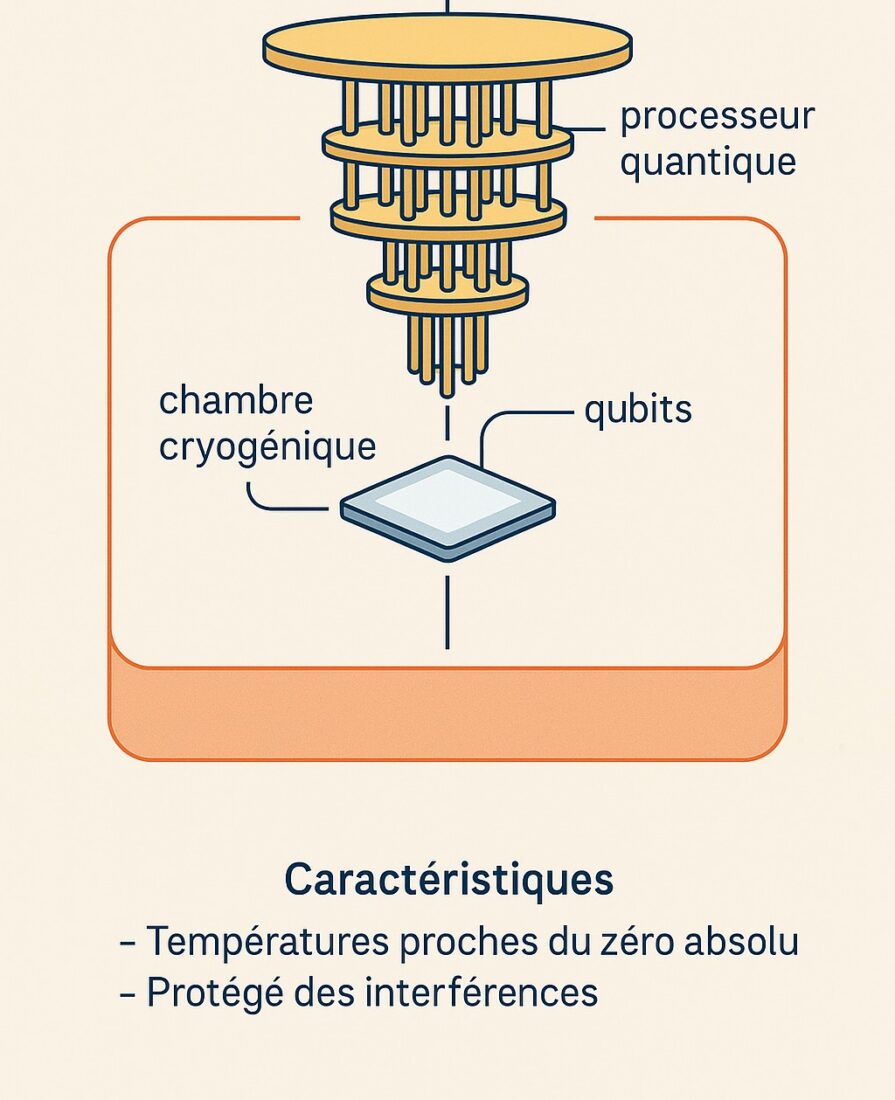

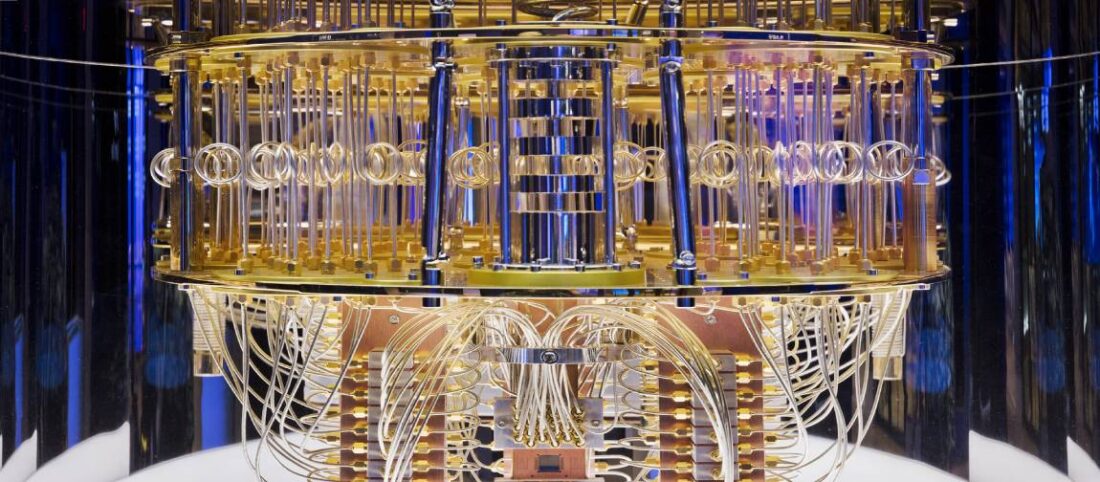

Mais cette puissance, aussi fascinante soit-elle, tient sur un fil. Un qubit est une entité extrêmement sensible. Le moindre bruit ambiant, une infime variation de température, un champ magnétique ou une vibration mécanique peut perturber son état. C’est ce qu’on appelle la décohérence : le moment où le qubit perd ses propriétés quantiques et devient inutilisable. Pour éviter cela, les processeurs quantiques doivent être maintenus dans des conditions extrêmes. On les place dans des chambres cryogéniques, à des températures proches du zéro absolu, soit environ -273,15 °C. À cette température, les atomes cessent presque de bouger, ce qui réduit considérablement les interférences. Les qubits doivent aussi être isolés dans des environnements ultra-propres, protégés des rayonnements, des ondes radio et même des vibrations produites par des pas dans un couloir adjacent. Ce sont des machines à la fois délicates et coûteuses, suspendues dans de grandes structures métalliques qui ressemblent à des chandeliers de science-fiction.

Aujourd’hui, l’informatique quantique reste expérimentale. Les machines sont dites NISQ, pour « Noisy Intermediate-Scale Quantum ». En clair, elles sont puissantes mais instables, incapables pour l’instant de livrer des résultats fiables à grande échelle. Les ordinateurs quantiques actuels ne sont pas complètement inutiles, mais ils ne sont pas encore entièrement fonctionnels .

Chaque nouveau processeur améliore un peu les choses, mais la bataille ne se joue pas seulement dans les circuits. Il faut apprendre à corriger les erreurs, à stabiliser les qubits et surtout à faire dialoguer cette technologie avec les ordinateurs classiques. C’est un chantier colossal qui mobilise les plus grands cerveaux de la planète.

Ce qu’on peut faire, et ce qu’on ne peut pas (encore)

Même si les promesses sont grandes, il faut rester lucide. À ce jour, il n’existe pas encore de percée technologique majeure dans le monde réel qui découle directement d’un calcul quantique. Aucune molécule découverte grâce à un ordinateur quantique, aucun matériau révolutionnaire, aucun médicament, aucune optimisation logistique massive ou percée en intelligence artificielle ne peut être attribué de façon incontestable à un calcul quantique.

À quoi sert l’informatique quantique (en théorie)

- Simuler des réactions chimiques ou moléculaires complexes

- Optimiser des réseaux (logistique, transport, chaînes d’approvisionnement)

- Résoudre des équations impossibles à modéliser classiquement

- Améliorer la cryptographie ou casser les codes actuels

- Générer des modèles de risques ou d’investissements en finance

- Simuler des comportements en physique des hautes énergies

Pour l’instant, aucune de ces applications n’a atteint le stade industriel.

Les avancées sont surtout des démonstrations de principe. On a réussi à simuler de petites molécules, à démontrer que certains problèmes théoriques peuvent être abordés autrement, ou à tester des algorithmes hybrides mêlant calcul classique et quantique. C’est encourageant, mais encore loin d’un usage quotidien ou industriel.

La véritable percée attendue, c’est ce qu’on appelle l’avantage quantique réel : le moment où un ordinateur quantique résoudra un problème pratique, utile, que même les meilleurs superordinateurs ne peuvent pas résoudre dans un délai réaliste. Cette course est en cours, et certains misent sur les cinq prochaines années pour y parvenir.

Et le Québec dans tout ça ?

IBM a inauguré à Bromont son Quantum System One, un superordinateur de 127 qubits. L’initiative est pilotée par la plateforme PINQ², en collaboration avec le gouvernement du Québec et plusieurs universités. L’objectif est clair : faire du Québec un pôle d’innovation quantique, et offrir cet outil aux chercheurs comme aux entreprises qui veulent développer des applications concrètes, dans la santé, l’énergie, la finance ou l’environnement.

De son côté, Calcul Québec a accueilli MonarQ, un ordinateur conçu ici même par Anyon Systems à Montréal. Il fait deux étages de haut et compte 24 qubits. Ce n’est pas une bête de course, mais c’est une première étape essentielle pour former la relève, tester les limites de la technologie et bâtir ce qui viendra ensuite.

À Sherbrooke, c’est tout un écosystème qui se met en place. L’Institut quantique, DistriQ, ACET Quantum et les universités de la région unissent leurs efforts. Un projet de réseau quantique reliant Sherbrooke, Montréal et Québec est même sur la table. Si ça se concrétise, la province pourrait se retrouver en tête de peloton sur la scène internationale.

L’informatique quantique n’est plus un mystère pour initiés. C’est une révolution discrète, fragile, mais déjà en marche. Et le Québec, sans tambour ni trompette, est bien décidé à y prendre part.